数据预处理将原始数据转换成符合要求的数据格式,对提升模型拟合效果具有重要意义.科研工作者通常根据实验要求提出合适数据预处理方式并进行相应处理.Arthur等[1]根据统计测试对药物效果的比较,得出需将数据正态化处理避免得到不当结果的结论.Zygmunt[2]讨论了对数据进行标准化处理的两种方法.马立平[3]注意到统计数据的可比性和综合性问题,提出统计数据无量纲化方法.这些数据处理方法可以使处理后的数据拟合出效果更好的模型[4],然而,目前尚无对这些简单数据预处理方式结合后对模型拟合效果影响的研究.

为了探究数据预处理对提升模型拟合效果的重要意义.本文基于UCI Machine Learning Repository[5-6]中3种有代表性的机器学习数据集,采用多种变量处理方式和变量选择方法组合,实验对比分析组合方法对经典机器学习模型拟合效果的影响.变量处理方式中,对比不处理、正态化、标准化、归一化4种基本情况,并比较了它们两两组合的情形;对于定性变量,对比是否引入哑变量的处理.变量选择方法中,本文将方差分析、卡方检验、互信息方法[7]与Copula熵方法[8]进行对比分析,整个数据预处理流程如图1所示.本文将讨论不同变量处理方式和变量选择方法对模型拟合产生的影响,进而分析各种数据预处理方法在不同模型中的使用情况.为使结论具有普遍性,同时在每个数据集上都可以使用各数据预处理方式,即数据集需要既包含定量变量又包含定性变量,所以本文基于Heart Disease数据集进行了二分类的实验,基于Abalone数据集进行了多分类的实验,基于Auto MPG数据集进行了回归的实验.通过对上述实验结果的分析,从数据集特征、模型类型、问题类型等角度,归纳总结了数据预处理方法选择的一般性规律,进而设计了用于数据预处理方法推荐的启发式算法,最后通过更广泛的实验,验证了上述一般性规律和启发式算法的有效性.

图1 数据预处理方式

Fig.1 Data preprocessing methods

1 数据预处理

Heart Disease数据集共包含75个属性,其中第58个属性num为响应变量,其余74个属性为预测变量.为了使预测结果具有较好的可解释性,本文采用cleveland.data中机器学习研究者推荐的13个属性来进行心脏病患病情况的预测.

1.1 数据类型分析和缺失值填补

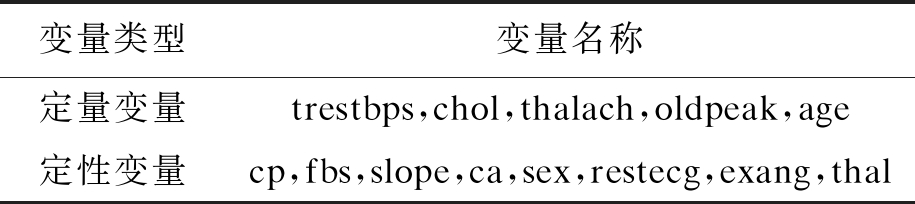

从原始数据集中各变量的含义分析,这13个变量中既包括定性变量,又包括定量变量,变量类型如表1所示.

表1 数据集中的变量类型

Tab.1 Types of variables in data set

变量类型变量名称定量变量trestbps,chol,thalach,oldpeak,age定性变量cp,fbs,slope,ca,sex,restecg,exang,thal

ca和thal的取值范围和数据说明不符,经核对超出范围的数字为缺失值,判定该数据集将缺失值填补为新的类别,为使其更合理,分别取ca和thal的众数来填补缺失值.

1.2 定量变量的转换

定量变量通常需要正态化、标准化以及归一化转换,这取决于所选择模型的特点.对于正态化,观察定量变量分布发现,trestbps、thalach和oldpeak的分布为正偏态分布,而chol的分布为负偏态分布,它们的分布与正态分布相比或多或少存在差异[9].通过多次实验发现,正态化处理时,将age和thalach做Box-Cox变换[10],将trestbps取倒数,将chol取对数,将oldpeak做Yeo-Johnson变换[11]后,使得原分布最接近正态分布.

1.3 定性变量因子化

数据集中的每种定性变量的类别采用数字进行编码,但由于模型不能通过数字识别出不同类别,反而会认为该变量存在大小关系,所以引入哑变量[12]将定性变量的不同类别替换为一个或多个取值为0或1的定性变量.

1.4 变量选择

该数据集的样本数量较少,而变量数量较多,考虑模型可能发生过拟合现象,于是进行变量选择来提升模型效果、提高训练速度,同时提升模型可解释性.而由所有变量间的相关性矩阵可以发现,该数据集中的变量两两之间相关性比较弱,绝对值均小于0.6,所以不能根据相关性选择变量.因此本文采用方差分析、卡方检验、互信息以及Copula熵4种方法进行变量选择.

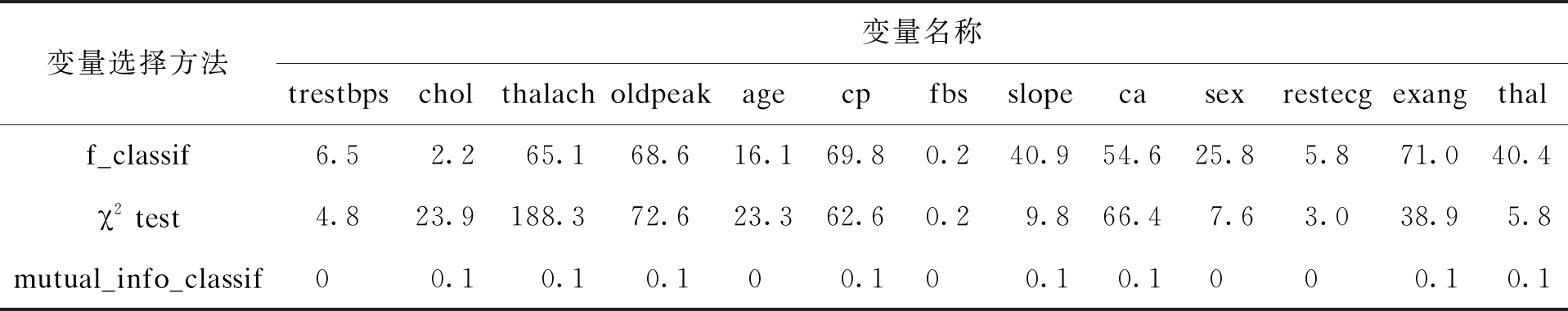

本文中方差分析、卡方检验、互信息分别使用sklearn库中f_classif、χ2 test、mutual_info_classif方法对变量依次打分,得到的得分情况如表2所示.

表2 变量得分情况

Tab.2 Score situation of variables

变量选择方法变量名称trestbpscholthalacholdpeakagecpfbsslopecasexrestecgexangthalf_classif6.52.265.168.616.169.80.240.954.625.85.871.040.4χ2 test4.823.9188.372.623.362.60.29.866.47.63.038.95.8mutual_info_classif00.10.10.100.100.10.1000.10.1

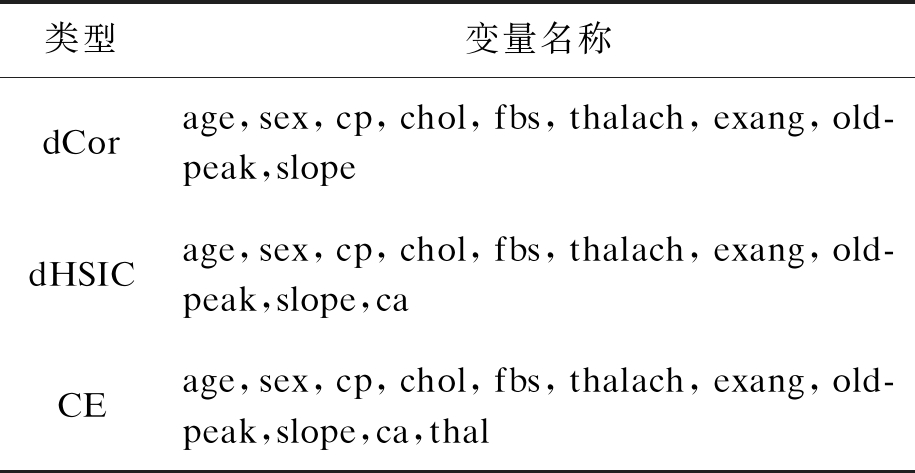

为了得到更高可解释性的预测结果,本实验中采用文献[13]中提出的CE方法、dHSIC[14]和dCor[15]3种方法选择的变量与研究人员推荐的13个变量对比找到重合的变量,即从中进行变量选择,dCor、dHSIC、CE选择出的变量情况如表3所示.

表3 dCor、dHSIC、CE选择出的变量名称

Tab.3 Name of variables selected by dCor,dHSIC and CE

类型变量名称dCorage,sex,cp,chol,fbs,thalach,exang,old-peak,slopedHSICage,sex,cp,chol,fbs,thalach,exang,old-peak,slope,caCEage,sex,cp,chol,fbs,thalach,exang,old-peak,slope,ca,thal

2 模型拟合与评估

将数据集以7∶3的比例分为训练集和测试集两部分,优化每种模型的超参数来找到“最佳模型”,采用常用于提高模型泛化能力的交叉验证方法划分训练集和验证集,采用网格搜索方法构造每种模型的参数网格,依次寻找最优超参数.

2.1 改变变量处理方式

为尽可能提升模型拟合效果,在前期对定量变量分别经过不处理、正态化、标准化、归一化、先正态化后标准化(简记“正标”)、先正态化后归一化(简记“正归”)、先标准化后归一化(简记“标归”)、先归一化后标准化(简记“归标”)、先正态化再标准化后归一化(简记“正标归”)、先正态化再归一化后标准化(简记“正归标”)处理后,再对定性变量进行是否引入哑变量的处理,这样得到20种处理方式,考虑正态化中Box-Cox变换需要的变量均为正数,故将正态化处理放在标准化与归一化前.完成数据预处理后,对数据采用逻辑回归、决策树、随机森林、支持向量机(SVM)、朴素贝叶斯(NB)、K近邻、神经网络7种经典模型拟合,将训练好的模型在测试集上做预测,对比准确率(Accuracy)、精确率(Precision)、召回率(Recall)、F-score、真阳率(TPR)、假阳率(FPR)、Area Under Curve(AUC)7个指标[16],找出表现最优的模型.多次实验得到结果如表4、5所示(表中加粗参数为最优值).

表4 模型拟合效果对比(不引入哑变量)

Tab.4 Comparison of model fitting effects (without dummy variables)

模型指标名称数据预处理方法不处理正态化标准化归一化正标正归标归归标正标归正归标逻辑回归决策树随机森林支持向量机朴素贝叶斯K近邻神经网络Accuracy0.91210.93410.90110.87910.92310.92310.87910.90110.86810.9231Precision0.90570.92450.90380.91670.89290.89290.91670.90380.93330.8929Recall0.94120.96080.92160.86270.98040.98040.86270.92160.82350.9804F-score0.92310.94230.91260.88890.93460.93460.88890.91260.87500.9346TPR0.94120.96080.92160.86270.98040.98040.86270.92160.82350.9804FPR0.12500.10000.12500.10000.15000.15000.10000.12500.07500.1500AUC0.94310.94750.95640.94460.94800.94410.94460.95640.94410.9480Accuracy0.78020.78020.78020.78020.78020.78020.78020.78020.78020.7802Precision0.84440.87800.84440.84440.87800.87800.84440.84440.87800.8780Recall0.74510.70590.74510.74510.70590.70590.74510.74510.70590.7059F-score0.79170.78260.79170.79170.78260.78260.79170.79170.78260.7826TPR0.74510.70590.74510.74510.70590.70590.74510.74510.70590.7059FPR0.17500.12500.17500.17500.12500.12500.17500.17500.12500.1250AUC0.78310.82700.78310.78310.82700.82700.78310.78310.82700.8270Accuracy0.86810.85710.84620.86810.86810.86810.86810.87910.86810.8681Precision0.88240.86540.83640.88240.88240.88240.88240.87040.88240.8824Recall0.88240.88240.90200.88240.88240.88240.88240.92160.88240.8824F-score0.88240.87380.86790.88240.88240.88240.88240.89520.88240.8824TPR0.88240.88240.90200.88240.88240.88240.88240.92160.88240.8824FPR0.15000.17500.22500.15000.15000.15000.15000.17500.15000.1500AUC0.94140.93190.92700.94070.94070.94120.94070.93920.94120.9407Accuracy0.76920.70330.86810.82420.86810.76920.82420.86810.76920.8681Precision0.76790.71430.85450.81820.84210.78850.81820.85450.78850.8421Recall0.84310.78430.92160.88240.94120.80390.88240.92160.80390.9412F-score0.80370.74770.88680.84910.88890.79610.84910.88680.79610.8889TPR0.84310.78430.92160.88240.94120.80390.88240.92160.80390.9412FPR0.32500.40000.20000.25000.22500.27500.25000.20000.27500.2250AUC0.83770.78970.93650.90780.93060.87600.90780.93600.87600.9304Accuracy0.90110.89010.90110.90110.86810.86810.90110.90110.86810.8681Precision0.92000.92000.92000.92000.88240.88240.92000.92000.88240.8824Recall0.90200.90200.90200.90200.88240.88240.90200.90200.88240.8824F-score0.91090.90200.91090.91090.88240.88240.91090.91090.88240.8824TPR0.90200.90200.90200.90200.88240.88240.90200.90200.88240.8824FPR0.10000.12500.10000.10000.15000.15000.10000.10000.15000.1500AUC0.95000.94900.95000.95000.95340.95340.95000.95000.95340.9534Accuracy0.75820.65930.89010.90110.90110.90110.90110.89010.90110.8791Precision0.77360.67860.90200.90380.90380.90380.90380.90200.90380.9000Recall0.80390.74510.90200.92160.92160.92160.92160.90200.92160.8824F-score0.78850.71030.90200.91260.91260.91260.91260.90200.91260.8911TPR0.80390.74510.90200.92160.92160.92160.92160.90200.92160.8824FPR0.30000.45000.12500.12500.12500.12500.12500.12500.12500.1250AUC0.78750.68280.94750.95290.95290.95930.95290.94750.95930.9424Accuracy0.43960.43960.87910.90110.76920.82420.83520.80220.79120.7802Precision--0.87040.93750.77780.88890.86000.82350.84780.8039Recall0.00000.00000.92160.88240.82350.78430.84310.82350.76470.8039F-score--0.89520.90910.80000.83330.85150.82350.80410.8039TPR0.00000.00000.92160.88240.82350.78430.84310.82350.76470.8039FPR0.00000.00000.17500.07500.30000.12500.17500.22500.17500.2500AUC0.50000.50000.87330.90370.76180.82970.83410.79930.79490.7770

根据7个指标选择模型拟合最优的处理方式,指标均相同时,选取最简单处理方式.拟合逻辑回归模型时,仅正态化处理;拟合决策树模型时,正态化、先正态化再标准化后归一化、先正态化再归一化后标准化处理拟合模型效果最好,但仅正态化处理最为简单;拟合随机森林模型时,选取先归一化再标准化处理;拟合支持向量机模型时,归一化处理并引入哑变量、先标准化再归一化并引入哑变量处理拟合模型7种指标均相同,简便起见,选取归一化且引入哑变量处理;拟合朴素贝叶斯模型时,不处理、标准化、归一化、先标准化再归一化、先归一化再标准化5种处理方式拟合模型7种指标均相同,简便起见,选取不处理变量;拟合K近邻模型时,选取先正态化再归一化处理;拟合神经网络模型时,仅归一化处理.

2.2 改变变量选择方法

根据2.1节实验结果可知,逻辑回归拟合效果最好;朴素贝叶斯、K近邻和神经网络拟合效果相似;支持向量机和随机森林拟合效果略差一点;决策树拟合效果较不理想,所以采用1.4节中变量选择且正态化处理重新拟合.

当删去restecg、fbs、trtbps且仅正态化处理时,模型准确率为87.912 1%,效果最好.而Copula熵方法没有提高模型准确率,仅小幅度提升了精确率.参考文献[13]中,SVM模型拟合准确率为84.76%,较本文不做任何数据处理拟合的准确率76.92%有很大提高,却不如采用合适变量处理结果,如对归一化且引入哑变量处理准确率达到89.01%.

表5 模型拟合效果对比(引入哑变量)

Tab.5 Comparison of model fitting effects (with dummy variables)

模型指标名称数据预处理方法不处理正态化标准化归一化正标正归标归归标正标归正归标逻辑回归决策树随机森林支持向量机朴素贝叶斯K近邻神经网络Accuracy0.87910.90110.87910.85710.89010.85710.85710.87910.85710.8901Precision0.90000.90380.90000.93180.88680.93180.93180.90000.93180.8868Recall0.88240.92160.88240.80390.92160.80390.80390.88240.80390.9216F-score0.89110.91260.89110.86320.90380.86320.86320.89110.86320.9038TPR0.88240.92160.88240.80390.92160.80390.80390.88240.80390.9216FPR0.12500.12500.12500.07500.15000.07500.07500.12500.07500.1500AUC0.94020.95050.93770.93040.93820.92840.93040.93770.92840.9382Accuracy0.75820.75820.76920.76920.75820.75820.76920.76920.75820.7582Precision0.77360.77360.80000.80000.77360.77360.80000.80000.77360.7736Recall0.80390.80390.78430.78430.80390.80390.78430.78430.80390.8039F-score0.78850.78850.79210.79210.78850.78850.79210.79210.78850.7885TPR0.80390.80390.78430.78430.80390.80390.78430.78430.80390.8039FPR0.30000.30000.25000.25000.30000.30000.25000.25000.30000.3000AUC0.74900.74900.81690.81690.74900.74900.81690.81690.74900.7490Accuracy0.84620.85710.84620.87910.85710.85710.87910.84620.85710.8571Precision0.83640.86540.83640.87040.86540.86540.87040.83640.86540.8654Recall0.90200.88240.90200.92160.88240.88240.92160.90200.88240.8824F-score0.86790.87380.86790.89520.87380.87380.89520.86790.87380.8738TPR0.90200.88240.90200.92160.88240.88240.92160.90200.88240.8824FPR0.22500.17500.22500.17500.17500.17500.17500.22500.17500.1750AUC0.92700.93190.92700.93380.93240.93240.93380.92700.93240.9324Accuracy0.71430.71430.87910.89010.84620.87910.89010.87910.87910.8462Precision0.72730.72730.88460.88680.82460.88460.88680.88460.88460.8246Recall0.78430.78430.90200.92160.92160.90200.92160.90200.90200.9216F-score0.75470.75470.89320.90380.87040.89320.90380.89320.89320.8704TPR0.78430.78430.90200.92160.92160.90200.92160.90200.90200.9216FPR0.37500.37500.15000.15000.25000.15000.15000.15000.15000.2500AUC0.82550.79070.93380.94850.92790.94750.94850.93380.94750.9275Accuracy0.85710.89010.85710.85710.82420.82420.85710.85710.82420.8242Precision0.93180.90200.93180.93180.90700.90700.93180.93180.90700.9070Recall0.80390.90200.80390.80390.76470.76470.80390.80390.76470.7647F-score0.86320.90200.86320.86320.82980.82980.86320.86320.82980.8298TPR0.80390.90200.80390.80390.76470.76470.80390.80390.76470.7647FPR0.07500.12500.07500.07500.10000.10000.07500.07500.10000.1000AUC0.89850.95340.89850.89850.89220.89220.89850.89850.89220.8922Accuracy0.75820.69230.89010.87910.87910.87910.87910.89010.87910.8791Precision0.76360.71700.88680.88460.90000.88460.88460.88680.88460.9000Recall0.82350.74510.92160.90200.88240.90200.90200.92160.90200.8824F-score0.79250.73080.90380.89320.89110.89320.89320.90380.89320.8911TPR0.82350.74510.92160.90200.88240.90200.90200.92160.90200.8824FPR0.32500.37500.15000.15000.12500.15000.15000.15000.15000.1250AUC0.81130.69930.94610.94800.95250.94460.94800.94610.94460.9525Accuracy0.56040.56040.84620.85710.78020.79120.83520.80220.80220.8022Precision0.56040.56040.84910.85190.79250.80770.84620.81130.82350.7797Recall1.00001.00000.88240.90200.82350.82350.86270.84310.82350.9020F-score0.71830.71830.86540.87620.80770.81550.85440.82690.82350.8364TPR1.00001.00000.88240.90200.82350.82350.86270.84310.82350.9020FPR1.00001.00000.20000.20000.27500.25000.20000.25000.22500.3250AUC0.50000.50000.84120.85100.77430.78680.83140.79660.79930.7885

3 多分类与回归实验

第2节通过二分类实验进行了数据预处理方法的比较分析,本节将探究多分类与回归实验中上述数据预处理方法对模型效果的影响.

基于Abalone数据集实验,为使模型拟合效果最好,拟合逻辑回归模型选取归一化且引入哑变量处理[17];拟合决策树模型引入哑变量处理;拟合随机森林模型仅进行正态化处理;拟合支持向量机模型引入哑变量处理[18];拟合朴素贝叶斯模型仅进行正态化处理;拟合K近邻模型不处理;拟合神经网络模型引入哑变量处理.

基于Auto MPG数据集实验,为使模型拟合效果最好,拟合线性回归模型仅进行正态化处理;拟合决策树模型先正态化再归一化后标准化处理;拟合随机森林模型先正态化再标准化处理;拟合支持向量机模型引入哑变量处理;拟合K近邻模型仅进行标准化处理;拟合Adaboost模型先正态化再标准化后归一化处理;拟合Bagging模型先正态化再归一化后标准化处理.

4 分析与讨论

数据预处理方法的选择本身很复杂,本节将从3个角度展开讨论,给出初步的分析结果.

4.1 从数据集自身特点分析

Heart Disease数据集通常需要正态化和归一化处理,根据该数据集自身特点,其age、thalach、trtbps、chol和oldpeak 5个变量分布的偏度较大,若不做正态化处理会对模型拟合效果产生一定影响;该数据集各变量的取值范围相差较大,如age取值从29~77,而chol取值从126~564,二者量纲显然不同,这就需要归一化处理使数据更为符合模型拟合的要求.

Abalone数据集通常需要引入哑变量处理,该数据集中仅有sex变量为定性变量,其他变量均为定量变量且连续.由于sex变量有M、F和I3种,如果不引入哑变量,数据会被认为三者存在大小关系,这不利于模型拟合.Auto MPG数据集通常需要正态化、标准化和归一化三者结合处理,分析该数据集特点,就需要归一化来统一量纲.

通常来说,定量变量分布的偏度较大时需要采用正态化处理;定量变量的方差较大时需要采用标准化处理;定量变量的取值范围相差较大时需要采用归一化来处理;定性变量含有多种类别同时并无大小关系时需要引入哑变量处理.

4.2 从模型类型分析

呈正态分布的数据拟合朴素贝叶斯模型和逻辑回归模型表现效果较好.朴素贝叶斯模型先验分布是正态分布,这样正态化处理的数据可以帮助模型拟合.而对于偏度和峰度较大的数据拟合的逻辑回归模型效果较差.

引入哑变量处理后的数据拟合的支持向量机模型表现效果较好.支持向量机模型只能处理数值型数据,所以需要将定性变量引入哑变量,将其转化为数值型数据,这样就可以更好地拟合模型.而不引入哑变量处理后的数据拟合的朴素贝叶斯模型、决策树和随机森林模型表现效果较好.

归一化处理的数据拟合K近邻模型表现效果较好,K近邻模型是度量距离的模型,避免极端数据的出现会帮助模型拟合.

4.3 从问题种类分析

基于Heart Disease数据集和Abalone数据集解决分类问题,不用选用3种数据预处理方式就可以达到最优拟合效果.而基于Auto MPG数据集解决回归问题通常需要将3种数据预处理方式结合起来才能够达到最优拟合效果.这说明数据预处理方法的结合对解决回归问题更为重要.

究其原因,回归问题基于贝叶斯统计学,如线性回归假设数据服从正态分布,所以正态化处理数据尤为重要;分类问题在某个阈值范围内均可以分到某个类别,而回归问题必须尽可能地接近真实值,这就需要提供的数据更加符合模型要求,以得到更加精确的结果.

4.4 算法合理性实验

本文从UCI Machine Learning Repository中选取Census Income数据集和Credit Approval数据集做二分类实验,选取Contraceptive Method Choice数据集和Mechanical Analysis数据集做多分类实验,选取Automobile数据集和Chess(King-Rook vs.King)数据集做回归实验.基于每个数据集进行所有数据预处理方法的实验,同时再使用数据预处理推荐算法选出最优数据预处理方法,并和实际最优数据预处理方法进行对比,检验该启发式算法的合理性.

4.5 实验结果分析

启发式算法与实际最优数据预处理方法相对差异如表6、7所示.算法结果和实际最优之间的相对差异表明,经过该数据预处理方法推荐算法选取的数据预处理后,仅有基于Census Income数据集的决策树模型、基于Credit Approval数据集的随机森林模型以及基于Contraceptive Method Choice数据集的支持向量机模型拟合效果优于或者等于实际最优的数据预处理方法.而其他情况下与拟合最优的数据预处理方法有一定差距.但绝大多数情况下,该数据预处理方法推荐算法选取的数据预处理方法拟合的模型比不做任何处理的拟合模型有明显优势,同时大多数情况下其与实际最优数据预处理方法拟合模型效果的相对差异在0.01之内,这足以说明如果采用本文提出的数据预处理方法推荐算法可以在一定程度上提升模型拟合效果,简化复杂的数据预处理过程,节约一定的时间成本.

表6 启发式算法与实际最优方法数据预处理方法相对差异(分类数据集)

Tab.6 Relative difference between data preprocessings selected by heuristic algorithm and actual optimal method (classification data set)

数据集模型逻辑回归决策树随机森林SVMNBK近邻神经网络Census Income0.0038940.0076330.0044330.0090420.0011110.0083170.007182Credit Approval0.0116690.0622300.0000000.0057450.0295170.0052330.156400Contraceptive Method Choice0.0612640.0090820.0086510.0040520.0657810.0309020.048723Mechanical Analysis0.0062300.0172630.0035250.0005890.0181950.0007000.014954

表7 启发式算法与实际最优方法数据预处理方法相对差异(回归数据集)

Tab.7 Relative difference between data preprocessings selected by heuristic algorithm and actual optimal method (regression data set)

数据集模型线性回归决策树随机森林SVMK近邻AdaboostBaggingAutomobile0.0525380.3214170.2192091.1021851.7914140.5355100.290232Chess(King-Rook vs.King)0.0000000.0000000.0000000.0165560.5000000.1163700.500000

对于回归问题,数据预处理方法推荐算法选取的数据预处理方法有几种模型拟合效果劣于不处理的情况,同时其与实际最优数据预处理方法拟合模型效果的相对差异都大于0.01.为了解决这一问题,需要进一步挖掘模型的特点,使得该数据预处理推荐算法对整个实验流程提供帮助.

5 结 论

本文从数据分析中归纳总结得出一些规则,并将这些规则表达成数据预处理推荐算法,最终在更广泛的数据上获得了验证.根据实验结果可知,本文提出的数据预处理推荐算法可以通过数据特征、模型特点以及研究问题种类等方面推荐数据预处理方法,并且可以一定程度上提升模型拟合效果,简化复杂的数据预处理过程,节约一定的时间成本.

[1]Arthur A,Eugene N,Bush D,et al.Data normalization before statistical analysis:keeping the horse before the cart [J].Trends in Pharmacological Sciences,1988,9(1):29-32.

[2]Zygmunt G.Some problems of data standardization [J].Quality and Quantity,1973,7(1):189-196.

[3]马立平.统计数据标准化——无量纲化方法——现代统计分析方法的学与用 [J].北京统计,2000(3):34-35.

(MA Li-ping.Statistical data standardization-dimensionless method-learning and application of modern statistical analysis methods [J].Beijing Statistics,2000(3):34-35.)

[4]肖立华,张博,胡伟,等.基于机器学习的电网工程量计价预测模型 [J].沈阳工业大学学报,2021,43(3):241-246.

(XIAO Li-hua,ZHANG Bo,HU Wei,et al.Forecasting model for power grid engineering quantity pricing based on machine learning [J].Journal of Shenyang University of Technology,2021,43(3):241-246.)

[5]Dua D,Graff C.UCI machine learning repository [D].California:University of California,2017.

[6]赵宇,黄思明.带有变量选择过程的分类模型误差分析 [J].数学的实践与认识,2010,40(17):200-209.

(ZHAO Yu,HUANG Si-ming.Error analysis of classification model with variable selection process [J].Mathematics in Practice and Theory,2010,40(17):200-209.)

[7]唐勇波,桂卫华,彭涛,等.基于互信息变量选择的变压器油中溶解气体浓度预测 [J].仪器仪表学报,2013,34(7):53-59.

(TANG Yong-bo,GUI Wei-hua,PENG Tao,et al.Prediction method for dissolved gas concentration in transformer oil based on variable selection of mutual information [J].Chinese Journal of Scientific Instrument,2013,34(7):53-59.)

[8]Ma J,Sun Z Q.Mutual information is copula entropy [J].Tsinghua Science and Technology,2011,16(1):51-54.

[9]王兆军,邹长亮.数理统计教程 [M].北京:高等教育出版社,2014.

(WANG Zhao-jun,ZOU Chang-liang.Mathematical statistics course [M].Beijing:Higher Education Press,2014.)

[10]高建,周丽萍.基于Box-Cox变换的住宅特征价格理论研究 [J].河北科技大学学报,2007(3):247-250.

(GAO Jian,ZHOU Li-ping.Study on housing hedonic price theory based on Box-Cox transformation [J].Journal of Hebei University of Science and Technology,2007(3):247-250.)

[11]He Y Y,Zheng Y.Short-term power load probability density forecasting based on Yeo-Johnson transformation quantile regression and Gaussian kernel function [J].Energy,2018,154:143-156.

[12]Gareth J,Daniela W,Trevor H,et al.An introduction to statistical learning with applications [M].New York:Springer,2013.

[13]马健.基于Copula熵的变量选择 [J].应用概率统计,2021,37(4):405-420.

(MA Jian.Variable selection with Copula entropy [J].Applied Probability and Statistics,2021,37(4):405-420.)

[14]Song L.Feature selection via dependence maximization [J].Journal of Machine Learning Research,2012,13:1393-1434.

[15]Li R Z,Wei Z,Zhu L P.Feature screening via distance correlation learning [J].Journal of the American Statistical Association,2012,107(99):1129-1139.

[16]周志华.机器学习 [M].北京:清华大学出版社,2016.

(ZHOU Zhi-hua.Machine learning [M].Beijing:Tsinghua University Press,2016.)

[17]雷大江,杜萌,李智星,等.稀疏多元逻辑回归问题优化算法研究 [J].重庆邮电大学学报(自然科学版),2019,31(3):354-366.

(LEI Da-jiang,DU Meng,LI Zhi-xing,et al.Research on optimization algorithm for sparse multinomial logistic regression problem [J].Journal of Chongqing University of Posts and Telecommunications (Natural Science Edition),2019,31(3):354-366.)

[18]陈思吉,王欣,申滨.一种基于支持向量机的认知无线电频谱感知方案 [J].重庆邮电大学学报(自然科学版),2019,31(3):313-322.

(CHEN Si-ji, WANG Xin,SHEN Bin.A support vector machine based spectrum sensing for cognitive radios [J].Journal of Chongqing University of Posts and Telecommunications (Natural Science Edition),2019,31(3):313-322.)